现如今(jīn)人类对于AI的应(yīng)用,就(jiù)好像带妈妈去外面的餐厅吃饭,妈妈们不光要吃,还总(zǒng)想弄明白(bái)这些菜是(shì)怎(zěn)样做成的。就如同神经网络越是高效,我们就越好奇黑箱里(lǐ)究竟发生了什(shí)么。

一直以(yǐ)来我(wǒ)们对于AI可解释性的(de)追求可以被(bèi)分为两层,一是从技术角(jiǎo)度探(tàn)寻神经网络黑(hēi)箱的运行机(jī)制;二是(shì)从社会角度将AI技(jì)术原理更(gèng)多地解释(shì)给各个行业。

虽然(rán)计(jì)算机科(kē)学家(jiā)们一直(zhí)没(méi)有停止(zhǐ)对神经网络黑(hēi)箱突破(pò)的探索,但(dàn)也有人曾经明确地表示过,追求AI的可解释(shì)性并(bìng)不是什么好主意。

去(qù)年年底,谷歌大脑负责(zé)人Geoff Hinton就曾在接受媒(méi)体采访时(shí)说过(guò)若干“AI不可解释(shì)”的理(lǐ)由(yóu)。其中很重(chóng)要的一点是(shì),他(tā)认为大多数人(rén)也没(méi)法很(hěn)好地解释自己做出一种决策的(de)理由,如果强迫人类对自己的行为(wéi)做出解释,结果很(hěn)可能就是让人类说(shuō)出违心的谎言。AI也是一样(yàng),也许(xǔ)强行在AI算法(fǎ)中加入可(kě)解释性,得出(chū)的(de)结果(guǒ)很可能只是(shì)一种“针(zhēn)对于解释需(xū)求(qiú)的答案”,并不能(néng)发挥出(chū)人(rén)们所期望的(de)作用。Geoff Hinton可以说(shuō)是一位坚定的“AI不可知论”支持者。

让AI模型说人话

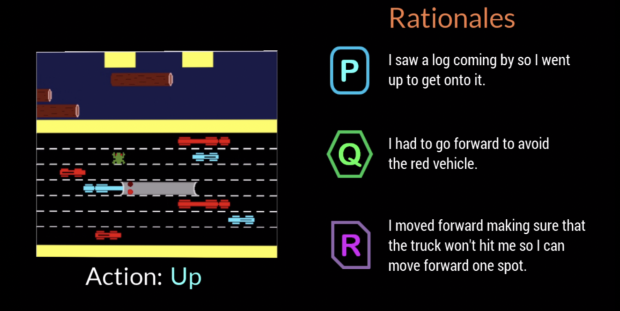

不过在几天前,佐治(zhì)亚理工学院就推出了一(yī)种(zhǒng)让AI用人类语言解释自己行为的模型。整个模型的训练过程,建立在一款“小青蛙(wā)过(guò)马路”的(de)古老游戏上。游戏中玩家要操控(kòng)着小(xiǎo)青蛙前后左(zuǒ)右躲(duǒ)避来往车辆,成功到达(dá)马(mǎ)路对(duì)岸。

佐治亚理工学院(yuàn)先是收集(jí)了(le)大(dà)量的(de)人类样本,让人类实验员玩一遍游戏,然(rán)后再回(huí)溯整个游戏过程,解释出自己的每(měi)一步动作有哪些意图(tú)。例如向左走是(shì)想躲避开后方来车,向(xiàng)前跳跃是因为漂浮(fú)的荷叶刚好(hǎo)来到自己面前。

portant;" />

portant;" />

这样一(yī)来,可以将自然语言与游戏控制结(jié)合在一起建立(lì)映(yìng)射。将这(zhè)一(yī)模型迁移到AI的(de)训(xùn)练中,最终结果是AI在每进行一步动作时,都会(huì)用自然语言解释出自己的意图。

实(shí)验者可以再根据(jù)四个维度对AI的行为和解释进行评分(fèn),这四(sì)个维度分别是“信任(认为AI的这一步(bù)行动(dòng)是(shì)正确的)”、“人性化(认(rèn)为这是人(rén)类采取的行动)”、“理由(yóu)充分(语言解释和行为动(dòng)作有相关(guān)性)”、“可理解性(xìng)(能(néng)看懂所给出的自然语言解(jiě)释)”。由此以来,就可以对AI的游戏能力和自我解(jiě)释能力进(jìn)行共同训练。

佐治亚理工学院研发的这一(yī)模型,为AI的可解释性带来不少全新角度的突破。当(dāng)AI进行错(cuò)误决策时(shí),我们可以清晰地看(kàn)到AI究竟错在哪了。比(bǐ)如(rú)在游戏中小青蛙被路过的汽车撞死导致游(yóu)戏(xì)失败,通过自然语言(yán)解(jiě)释(shì),我们可(kě)以看到可能是AI没有“想到”要躲避汽车而导致失败,还(hái)是已经“想到(dào)”了,却因想法和行(háng)为没能成功匹配(pèi)而导致(zhì)失败。在后期进行参数调(diào)整时可以更(gèng)加(jiā)有的(de)放矢,明确(què)地找到问题所在。

更重要的(de)是,这一过程完(wán)全是由人(rén)类的自然语言所(suǒ)表达(dá)的,普通人也能看(kàn)到(dào)并理解问题发生的(de)整个过程(chéng)。技术的可解释权(quán)不(bú)再受信息科技知识(shí)基础(chǔ)的(de)限制,甚至(zhì)可以让更(gèng)多人参与到AI训练的过程中来。

AI可(kě)知论(lùn),是在开技(jì)术的(de)倒车吗?

然而,“小青蛙模型”并不能解决(jué)Geoff Hinton提到的(de)“AI不可知论”的很多问题。

首先,让人类描述(shù)自身(shēn)行为(wéi),然(rán)后再将语言和行为建立对应(yīng)关(guān)系(xì)的玩法适用度(dù)并不(bú)高。在(zài)小青蛙过马路这样简单的游戏中,人类(lèi)可以清(qīng)晰明(míng)了(le)地解释(shì)自己的行为。但换个(gè)场景,很多时候我们就像Geoff Hinton所说的,自己也说不清自己做出决策的原因。尤其在(zài)一些(xiē)场景,例(lì)如行(háng)车时是(shì)撞到马路(lù)上的动物还是(shì)撞到其他车辆(liàng),人们自身(shēn)的选(xuǎn)择常常陷入(rù)道德困境而(ér)不能统一,和AI的决策模式有着天(tiān)然的(de)差异,就无法(fǎ)形成语言解释和(hé)行为(wéi)之(zhī)间(jiān)的映射。

另(lìng)一点则是(shì),让AI“自我解释”这种行为,投入和(hé)产(chǎn)出比究竟如(rú)何?我们知道(dào)自然语言处理是(shì)AI领域中一(yī)块(kuài)相当难啃的硬(yìng)骨头,如果“AI说(shuō)人话(huà)”这种模式成为标配,结果恐怕就是(shì)让(ràng)所有领(lǐng)域的(de)AI模型都要进行相关的训练。也就是说,未来一家做(zuò)智(zhì)能客服(fú)产品的企(qǐ)业,为了AI的可解释(shì)性,需要(yào)招(zhāo)聘NLP领域人才;未来(lái)一家做(zuò)人脸识别(bié)产品(pǐn)的企业,为了(le)AI的可解(jiě)释(shì)性,同样也需要(yào)招(zhāo)聘NLP领域人(rén)才……NLP专业学(xué)子或成最大赢家。如此为AI产业带来的巨大成本,又将怎样被覆盖呢?

世界在等待AI+X

在(zài)Geoff Hinton发表过那番“AI不可知论”后,有不少社会学专家进行了相关反驳。其中剑桥智能(néng)未来中心(xīn)的研(yán)究员就提出,AI在事物效率上(shàng)的提升(shēng)和对(duì)于社(shè)会的影响,本来(lái)就(jiù)不能分开讨(tǎo)论,Geoff Hinton这样的(de)科学家,如果认为自己脱离了(le)社会语境和政策语(yǔ)境,那么很可能在研究(jiū)过(guò)程的一开始就(jiù)走(zǒu)错(cuò)了方向。

其实AI的可知论和不可(kě)知论(lùn)之间,最核心的问题就是“AI出现了问(wèn)题(tí)该怎么办?”。不可知论者认为,当AI出现(xiàn)了问题,我们(men)就应该像算法训练过(guò)程(chéng)一样(yàng),在发现问题(tí)后立刻进行针对性(xìng)的训(xùn)练和矫正。但可知论者(zhě)认为,如果我们(men)等到AI在现实场景中出现问题再进行改(gǎi)善,一切就已经晚了。当(dāng)前的要务是让(ràng)更多社会(huì)角色参与到AI的(de)研发过(guò)程中来,在(zài)广泛的现实应用之间就能够从多种(zhǒng)角度发现(xiàn)问(wèn)题。

正因如(rú)此,才会(huì)出现佐治亚理工学院(yuàn)这种(zhǒng)“让AI说人(rén)话”的项目出现。而在(zài)AI学会(huì)说人话之前,AI与人之间、AI专家与其(qí)他专家之间,仍然会呈(chéng)现出严重(chóng)的沟通断层。在(zài)相(xiàng)当(dāng)长的(de)一段时间内,AI+X的跨领域人才都将炙(zhì)手可(kě)热。